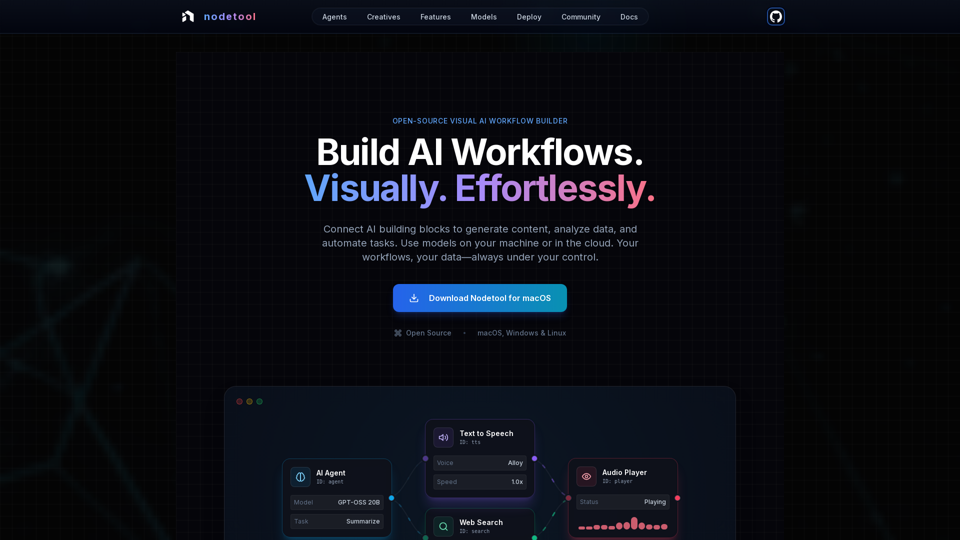

Nodetool AI 产品特点

概述

Nodetool AI 是一款开源、本地优先的可视化 AI 工作流构建工具,用于创建高级 LLM 代理、RAG 流水线和多模态数据流。它结合了基于节点的界面与强大的自动化功能,专为 AI 任务设计,强调隐私保护、本地执行和用户控制。

主要用途及目标用户群

- 主要用途: 提供一个统一、可视化且无需编码的平台,用于构建、运行和部署复杂的 AI 工作流,涵盖生成式 AI、媒体流水线、自主代理及文档智能等。

- 目标用户群: AI 开发者、数据科学家、研究人员、创意工作者以及任何希望构建和自动化 AI 应用而无需大量编码的用户,特别适合注重隐私、本地控制和开源方案的用户。

功能细节与操作

-

可视化工作流自动化:

- 拖拽式画布,用于协调 LLM、数据工具和 API。

- 类型安全连接,保证工作流完整性。

- 实时执行监控和逐步检查,实现透明调试。

-

生成式 AI 与媒体流水线:

- 连接节点实现视频生成、文本分析、图像创作和多模态处理。

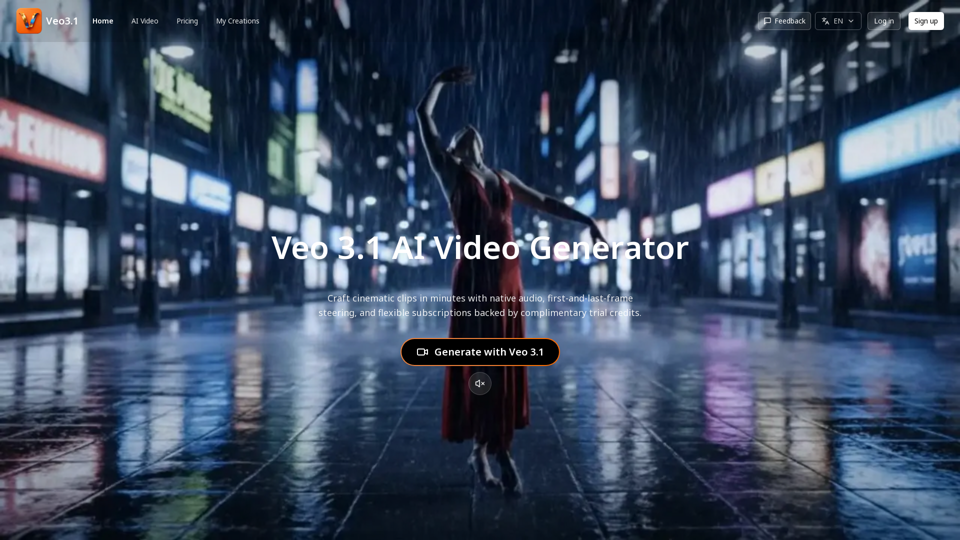

- 支持 Flux、SDXL、OpenAI Sora、Google Veo 及自定义模型。

-

本地优先的 RAG 与向量数据库:

- 在本地机器上完成文档索引和语义搜索流水线构建。

- 集成 ChromaDB 实现 RAG。

-

自主 AI 代理:

- 构建具备网页搜索、浏览、工具使用能力及多代理系统的复杂任务解决方案。

-

开源与隐私优先架构:

- 采用 AGPL-3.0 许可证,允许用户审查、修改及自托管。

- 本地优先处理确保数据隐私,无数据收集,无遥测,仅在用户选择下使用云服务。

- 下载模型后支持离线运行。

-

部署灵活性:

- 工作流可本地运行以确保隐私,亦可部署至云端服务(RunPod、Google Cloud、自定义服务器)。

- 一条命令部署(

nodetool deploy),自动配置基础设施、下载模型和设置容器。 - 支持零扩展,仅为实际推理时间付费。

-

通用模型支持:

- 本地推理:

- MLX(针对 Apple Silicon 优化,支持 LLM、音频、图像生成)。

- Ollama(便捷设置本地 LLM)。

- llama.cpp(跨平台的 GGUF 模型 CPU/GPU 推理)。

- vLLM(具备分页注意力的生产级服务)。

- Nunchaku(高性能支持 Flux、Qwen、SDXL)。

- 云端提供商:

- 直接集成 OpenAI、Anthropic、Gemini、OpenRouter、Cerebras、Minimax、HuggingFace、Fal AI、Replicate、Kie.ai 的 API 密钥。

- 可在单一工作流中混合多家提供商服务。

- 模型管理: 直接在应用内搜索、下载和管理 HuggingFace Hub 的模型权重。

- 本地推理:

-

多模态能力:

在单一工作流中处理文本、图像、音频和视频。 -

丰富的构建组件:

超过 1000 个现成组件,涵盖 AI 模型、数据处理、文件操作、计算、控制等多种功能。 -

聊天助手:

通过自然对话交互操作和执行工作流。 -

内置资产管理器:

集中管理图片、音频、视频和文档(支持 PNG、JPG、GIF、SVG、WebP、MP3、WAV、MP4、MOV、AVI、PDF、TXT、JSON、CSV、DOCX 等格式)。

用户优势

- 易用性: 无需编码即可构建复杂 AI 工作流,让先进 AI 技术触手可及。

- 透明性与调试性: 实时执行与逐步检查提供全流程可见性,确保工作流运行无忧。

- 隐私与控制: 数据与模型均保留本地,最大化隐私保护与所有权。

- 灵活性: 可选择本地运行或云端部署,支持丰富多样的本地与云端模型。

- 成本效益: 利用本地推理降低云计算成本,部署后实现零扩展付费。

- 多样性: 可构建广泛的 AI 应用,从代理、RAG 到创意流水线及数据处理。

- 社区支持: 开源特性促进社区贡献、共享工作流及与开发者直接交流。

兼容性与集成

- 操作系统: macOS、Windows、Linux。

- 硬件要求: 需要 Nvidia GPU 或 Apple Silicon M1 及以上,且至少 20GB 可用空间用于模型下载。

- 云端部署: 支持 RunPod、Google Cloud 及自定义服务器。

- API 集成: 支持 OpenAI、Anthropic、Gemini、OpenRouter、Cerebras、Minimax、HuggingFace、Fal AI、Replicate、Kie.ai。

- 本地模型支持: MLX、Ollama、llama.cpp、vLLM、Nunchaku。

访问与激活方式

- 下载方式: 可从官方网站直接下载 macOS、Windows 和 Linux 版本。

- 开源授权: 用户可审查、修改并自托管完整技术栈,遵循 AGPL-3.0 开源协议。