Hauptzweck und Zielgruppe

- Zweck: Vereinfachung von Web-Scraping und Automatisierung der Datenextraktion von Webseiten.

- Zielgruppen:

- Datenanalysten

- E-Commerce-Manager

- Marktforscher

- SEO-Spezialisten

- Unternehmer und Kleinunternehmer

- Softwareingenieure

Funktionsdetails und Vorgänge

Kernfunktionen

-

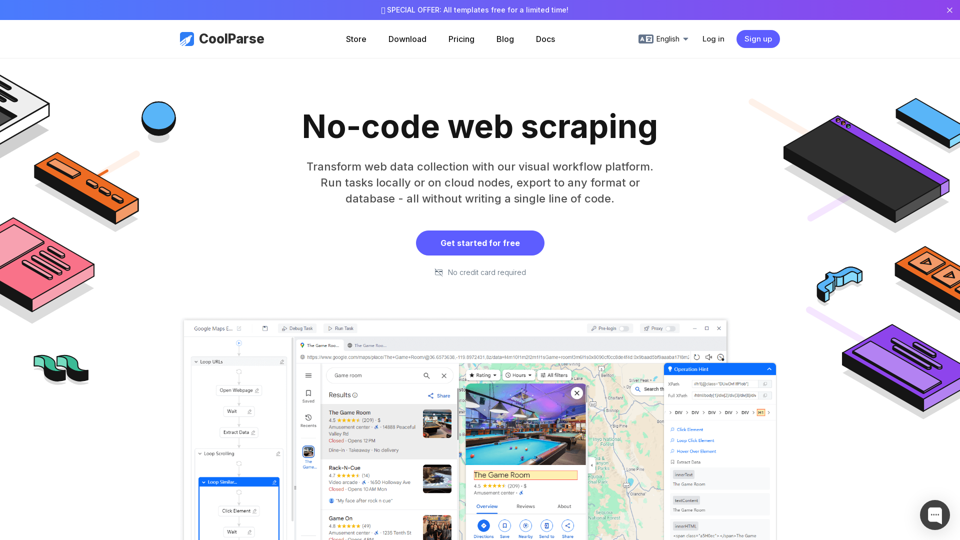

No-Code Visual Task Builder

- Drag-and-Drop-Oberfläche zum Erstellen von Scraping-Workflows.

- Intelligente Mustererkennung zur automatischen Generierung von Scraping-Regeln.

-

Vorgefertigte Scraping-Vorlagen

- Bereit nutzbare Vorlagen für Google Maps, Google Search, Amazon und mehr.

- Anpassbare Parameter (Schlüsselwörter, Standorte, Pagination).

-

Hochgeschwindigkeits- & Intelligentes Scraping

- Doppelte Engine-Technologie für gleichzeitige Anfragen.

- Automatische Erkennung von Seitenelementen mit XPath-Vorschlägen.

-

Datenverarbeitung & Export

- Über 18 Datenreinigungstechniken (Filtern, Formatieren, Duplikatentfernung).

- Export in 7 Dateiformate (Excel, CSV, JSON, XML, etc.).

- Direkte Datenbankintegration (MySQL, PostgreSQL, MongoDB, etc.) und API-Integration.

-

Aufgabenmanagement & Automatisierung

- Geplantes Scraping für kontinuierliche Datenaktualisierungen.

- Automatische Checkpoint-Speicherung zum Fortsetzen unterbrochener Aufgaben.

-

Anti-Scraping-Umgehung

- Simuliert menschliches Verhalten, um IP-Sperrungen zu vermeiden.

- Unterstützt Proxies und Anpassung der Ratenbegrenzung.

Zusätzliche Tools

- Mehrsprachige Unterstützung (Englisch, Chinesisch, Spanisch, etc.).

- Utility-Toolkit (MD5/Hash-Validierung, Base64-Codierung, URL-Codierung).

Nutzer-Vorteile

- Zeitersparnis: Reduziert die manuelle Datensammlung um 90%.

- Genauigkeit: Sichert 100% Datenaufnahme durch intelligente Verarbeitung – ideal für Datenanalyse.

- Benutzerfreundlichkeit: Kein Programmieren erforderlich – perfekt für nicht-technische Anwender.

- Skalierbarkeit: Cloudbasierte Ausführung für groß angelegtes Web-Scraping.

- Kosten-Effizienz: Spart Kosten für kundenspezifische Entwicklung und API-Integration.

Kompatibilität und Integration

- Unterstützte Webseiten: Funktioniert mit jeder Webseite, einschließlich dynamischer, JS-intensiver Seiten.

- Datenbankunterstützung: MySQL, PostgreSQL, Oracle, MongoDB und weitere.

- Dateiformate: Excel, CSV, JSON, XML, TXT, YAML, HTML.

- Betriebssysteme: Windows, macOS, Linux (über Cloud-Knoten).

Kundenfeedback und Fallstudien

- Jennifer Wilson (Datenanalystin): "Verbesserte Effizienz um 50% durch automatisiertes Scraping."

- Michael Zhang (E-Commerce-Manager): "Ein Game-Changer für die Extraktion von Produktdaten."

- Emma Watson (Marktforscherin): "Geplantes Scraping ist ideal für die Echtzeitüberwachung."

- David Park (Softwareingenieur): "Die besten Anti-Scraping-Strategien – seltene IP-Sperrungen."

Zugangs- und Aktivierungsmethode

- Kostenlose Testversion: 14-tägige Premium-Testphase (keine Kreditkarte erforderlich).

- Preispläne: Flexible Abonnements für Einzelpersonen und Unternehmen.

- Download & Cloud-Nutzung: Verfügbar für lokale Installation oder cloudbasierte Ausführung.

- Sofortige Einrichtung: Anmeldung unter CoolParse.com.

CoolParse befähigt seine Nutzer, Webdaten mühelos zu extrahieren, zu verarbeiten und zu nutzen – eine ideale Lösung für Unternehmen und Fachleute weltweit. 🚀