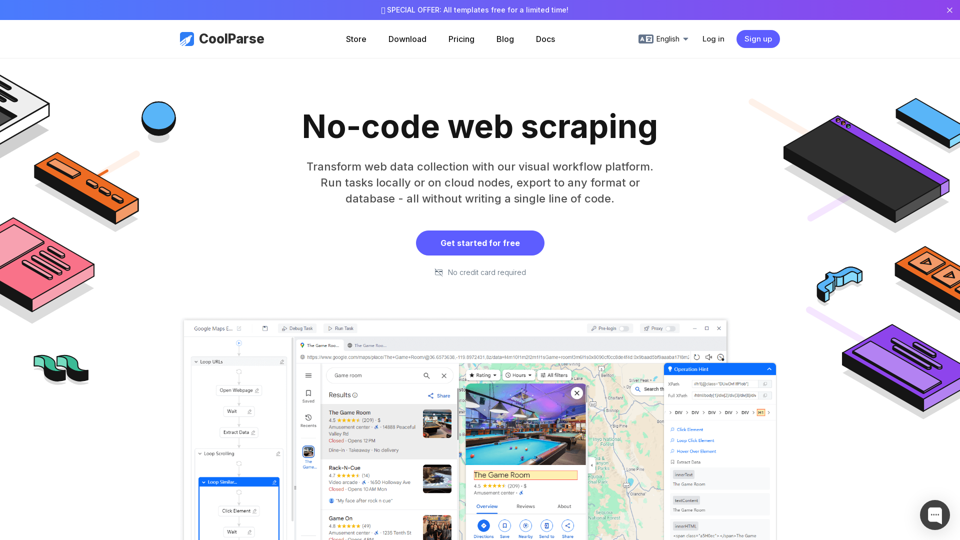

Objectif principal et groupe d'utilisateurs ciblé

- Objectif : Simplifier le scraping, l'analyse de données et automatiser l'extraction web depuis des sites internet.

- Utilisateurs ciblés :

- Analyse de données

- Responsables e-commerce

- Chercheurs en étude de marché

- Spécialistes SEO

- Entrepreneurs & propriétaires de petites entreprises

- Ingénieurs logiciels

Détails des fonctions et opérations

Fonctionnalités principales

-

Constructeur de tâches visuel sans code

- Interface de glisser-déposer pour créer des workflows de scraping.

- Reconnaissance intelligente des motifs pour générer automatiquement des règles de scraping.

-

Templates de scraping préconçus

- Modèles prêts à l'emploi pour Google Maps, Google Search, Amazon et bien plus.

- Paramètres personnalisables (mots-clés, emplacements, pagination).

-

Scraping rapide et intelligent

- Technologie Double-Engine pour des requêtes simultanées.

- Auto-détection des éléments de page avec suggestions XPath pour optimiser l'extraction web.

-

Traitement et exportation des données

- Plus de 18 techniques de nettoyage de données (filtrage, mise en forme, déduplication).

- Exportation vers 7 formats de fichiers (Excel, CSV, JSON, XML, etc.).

- Intégration directe avec des bases de données (MySQL, PostgreSQL, MongoDB, etc.).

-

Gestion des tâches et automatisation

- Scraping planifié pour des mises à jour de données continues.

- Points de sauvegarde auto-enregistrés pour reprendre les tâches interrompues.

-

Contournement anti-scraping

- Simule un comportement humain pour éviter le blocage des adresses IP.

- Prise en charge des proxies et ajustements du taux de requêtes.

Outils complémentaires

- Support multilingue (Anglais, Chinois, Espagnol, etc.).

- Boîte à outils utilitaires (Validation MD5/Hash, encodage Base64, encodage URL).

Avantages pour l'utilisateur

- Gain de temps : Réduction de 90 % de la collecte manuelle des données.

- Précision : Capture garantie à 100 % grâce à une analyse de données intelligente.

- Facilité d'utilisation : Aucune connaissance en codage requise — idéal pour les utilisateurs non techniques.

- Scalabilité : Exécution cloud pour supporter le scraping à grande échelle.

- Rentabilité : Élimine le besoin de développement sur mesure ou de coûts d'API grâce à l'automatisation.

Compatibilité et intégration

- Sites supportés : Fonctionne avec n'importe quel site web, y compris les pages dynamiques riches en JavaScript.

- Support des bases de données : MySQL, PostgreSQL, Oracle, MongoDB, et bien d'autres.

- Formats de fichiers : Excel, CSV, JSON, XML, TXT, YAML, HTML.

- Systèmes d'exploitation : Windows, macOS, Linux (via nœuds cloud).

Retour des clients et études de cas

- Jennifer Wilson (Analyste de données) : "L'automatisation via CoolParse a amélioré notre efficacité de 50 % avec un scraping intelligent."

- Michael Zhang (Responsable e-commerce) : "Un véritable changement de jeu pour l'extraction web de données produits."

- Emma Watson (Chercheuse en étude de marché) : "Le scraping planifié est parfait pour une surveillance en temps réel."

- David Park (Ingénieur logiciel) : "Les stratégies anti-scraping sont les meilleures, nous rencontrons rarement des blocages IP."

Méthodes d'accès et d'activation

- Essai gratuit : Version premium d'essai de 14 jours (aucune carte de crédit requise).

- Plans tarifaires : Abonnements flexibles pour particuliers et entreprises.

- Téléchargement & utilisation cloud : Disponible pour une exécution locale ou dans le cloud.

- Installation instantanée : Inscrivez-vous sur CoolParse.com.

CoolParse permet aux utilisateurs d'extraire, de traiter et d'exploiter les données web avec une extraction web simplifiée, une analyse de données performante et une automatisation efficace, en faisant le choix numéro un pour les professionnels et entreprises du monde entier. 🚀