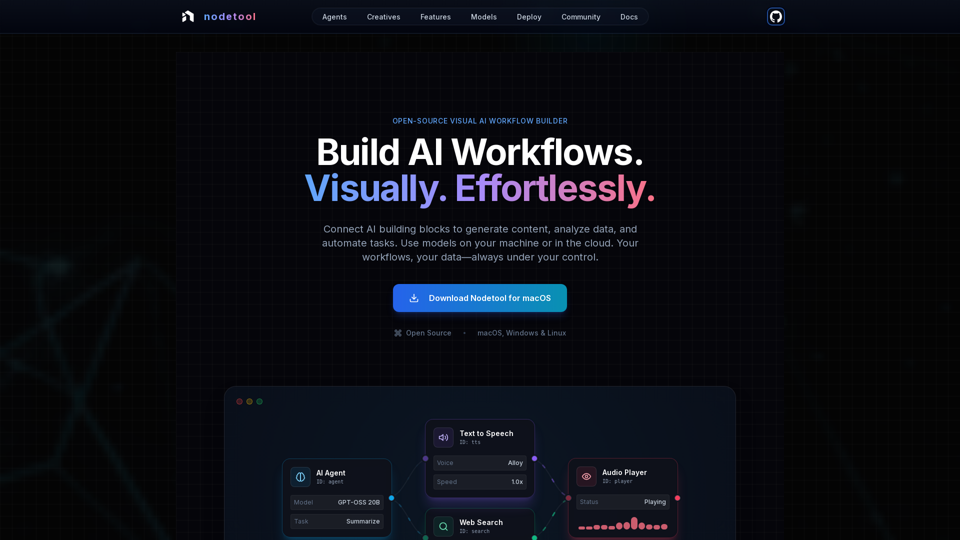

Fonctionnalités du produit Nodetool AI

Aperçu

Nodetool AI est un constructeur de flux de travail IA visuel open-source, local-first, permettant de créer des agents LLM avancés, des pipelines RAG et des flux de données multimodaux. Il combine des interfaces basées sur des nœuds avec des capacités d’automatisation puissantes, spécifiquement conçues pour les tâches IA, en mettant l’accent sur la confidentialité, l’exécution locale et le contrôle utilisateur.

Objectif principal et groupe cible

- Objectif principal : Fournir une plateforme unifiée, visuelle et sans code pour construire, exécuter et déployer des workflows IA complexes, allant de l’IA générative et des pipelines médias aux agents autonomes et à l’intelligence documentaire.

- Groupe cible : Développeurs IA, data scientists, chercheurs, créatifs, et toute personne souhaitant construire et automatiser des applications IA sans codage intensif, avec une forte préférence pour la confidentialité, le contrôle local et les solutions open-source.

Détails fonctionnels et opérations

-

Automatisation visuelle des workflows :

- Canevas en glisser-déposer pour orchestrer LLM, outils de données et APIs.

- Connexions typées assurant l’intégrité des workflows.

- Surveillance en temps réel de l’exécution et inspection étape par étape pour transparence et débogage.

-

IA générative & pipelines médias :

- Connectez des nœuds pour la génération vidéo, l’analyse texte, la création d’images et le traitement multimodal.

- Supporte des modèles comme Flux, SDXL, OpenAI Sora, Google Veo, et des modèles personnalisés.

-

RAG & bases de données vectorielles local-first :

- Indexez des documents et construisez des pipelines de recherche sémantique entièrement sur la machine locale.

- ChromaDB intégré pour RAG.

-

Agents IA autonomes :

- Construisez des agents capables de recherche web, navigation, utilisation d’outils et systèmes multi-agents pour résoudre des tâches complexes.

-

Architecture open source et privacy-first :

- Sous licence AGPL-3.0, permettant inspection, modification et auto-hébergement.

- Traitement local-first garantissant la confidentialité des données ; aucune collecte, pas de télémétrie, cloud sur opt-in uniquement.

- Fonctionne hors ligne une fois les modèles téléchargés.

-

Flexibilité de déploiement :

- Exécutez les workflows localement pour une confidentialité maximale ou déployez sur des services cloud (RunPod, Google Cloud, serveurs personnalisés).

- Déploiement en une commande (

nodetool deploy) pour provisionner l’infrastructure, télécharger les modèles et configurer les conteneurs. - Scalabilité à zéro, paiement uniquement pour le temps d'inférence actif.

-

Support universel des modèles :

- Inférence locale :

- MLX (optimisé Apple Silicon pour LLM, audio, génération d’images).

- Ollama (configuration facile pour LLM locaux).

- llama.cpp (inférence cross-plateforme GGUF sur CPU/GPU).

- vLLM (serveur de production avec PagedAttention).

- Nunchaku (haute performance pour Flux, Qwen, SDXL).

- Fournisseurs cloud :

- Intégration directe des clés API pour OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai.

- Mixez et assortissez les fournisseurs dans un même workflow.

- Gestion des modèles : Recherchez, téléchargez et gérez les poids des modèles depuis HuggingFace Hub directement dans l’application.

- Inférence locale :

-

Capacités multimodales :

Traitez texte, image, audio et vidéo dans un seul workflow. -

Blocs de construction étendus :

Plus de 1000 composants prêts à l’emploi pour modèles IA, traitement de données, opérations sur fichiers, calcul, contrôle, et plus. -

Assistant de chat :

Interagissez avec et exécutez les workflows via une conversation naturelle. -

Gestionnaire d’actifs intégré :

Gestion centralisée des images, audio, vidéo, documents (PNG, JPG, GIF, SVG, WebP, MP3, WAV, MP4, MOV, AVI, PDF, TXT, JSON, CSV, DOCX).

Avantages pour l’utilisateur

- Accessibilité : Construisez des workflows IA complexes sans coder, rendant l’IA avancée accessible à tous.

- Transparence & débogage : Exécution en temps réel et inspection pas à pas offrant une visibilité totale et une confiance dans l’opération du workflow.

- Confidentialité & contrôle : Maintenez les données et modèles localement, garantissant confidentialité maximale et propriété.

- Flexibilité : Exécutez localement ou déployez dans le cloud, en utilisant une large gamme de modèles locaux et cloud.

- Rentabilité : Profitez de l’inférence locale pour réduire les coûts cloud et scalabilité à zéro pour les workflows déployés.

- Polyvalence : Créez une grande variété d’applications IA, d’agents et RAG à des pipelines créatifs et traitement de données.

- Support communautaire : Nature open-source favorisant contributions communautaires, partage de workflows et accès direct aux développeurs.

Compatibilité et intégration

- Systèmes d’exploitation : macOS, Windows, Linux.

- Exigences matérielles : GPU Nvidia ou Apple Silicon M1+ et au moins 20 Go d’espace libre pour les téléchargements de modèles.

- Déploiement Cloud : RunPod, Google Cloud, et serveurs personnalisés.

- Intégrations API : OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai.

- Support des modèles locaux : MLX, Ollama, llama.cpp, vLLM, Nunchaku.

Méthode d’accès et d’activation

- Téléchargement : Disponible en téléchargement direct sur macOS, Windows et Linux depuis le site officiel.

- Open Source : Les utilisateurs peuvent inspecter, modifier et auto-héberger la pile complète étant donné que c’est open-source sous licence AGPL-3.0.