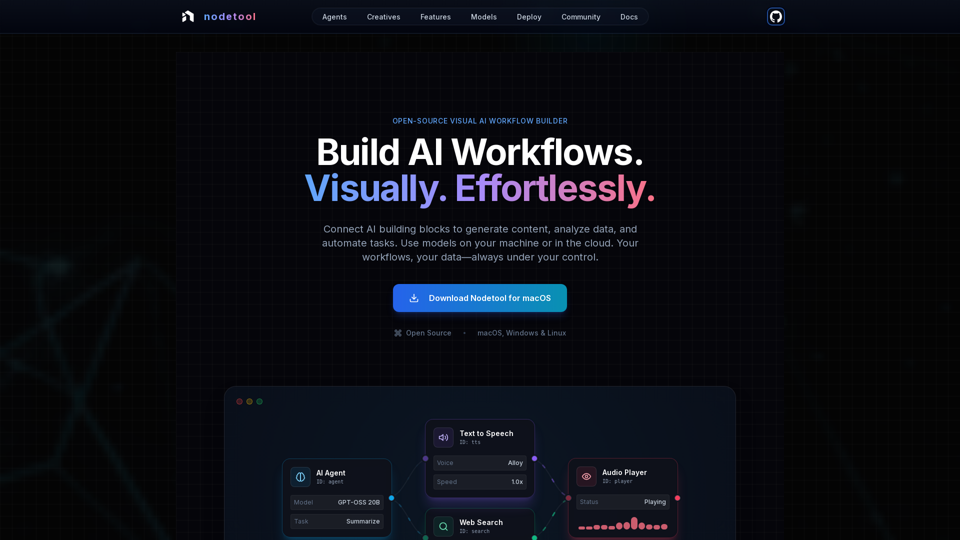

Nodetool AIの製品特徴

概要

Nodetool AIは、先進的なLLMエージェント、RAGパイプライン、多モーダルデータフローの構築に特化したオープンソースのローカルファーストなビジュアルAIワークフロービルダーです。ノードベースのインターフェースと強力な自動化機能を組み合わせ、プライバシー、ローカル実行、ユーザーコントロールを重視したAIタスク向けに設計されています。

主な目的と対象ユーザー

- 主な目的: 生成AIやメディアパイプラインから、自律型エージェントやドキュメントインテリジェンスまで、複雑なAIワークフローをコード不要で視覚的に構築、実行、デプロイできる統合プラットフォームを提供。

- 対象ユーザー: AI開発者、データサイエンティスト、研究者、クリエイター、そしてプライバシーやローカル制御、オープンソースを重視しながら、コーディングなしでAIアプリケーションを構築・自動化したいすべてのユーザー。

機能詳細と操作

-

ビジュアルワークフロー自動化:

- LLM、データツール、APIをオーケストレーションするドラッグ&ドロップキャンバス。

- 型安全な接続でワークフローの整合性を確保。

- リアルタイムの実行監視とステップバイステップの検査で透明性とデバッグ性を実現。

-

生成AI&メディアパイプライン:

- 動画生成、テキスト分析、画像生成、多モーダル処理用ノードを接続可能。

- Flux、SDXL、OpenAI Sora、Google Veo、カスタムモデルをサポート。

-

ローカルファーストRAG&ベクターデータベース:

- すべてローカルマシン上でドキュメントをインデックス化し、セマンティック検索パイプラインを構築。

- ChromaDBを統合したRAG対応。

-

自律型AIエージェント:

- ウェブ検索、ブラウジング、ツール利用、多エージェントシステムを実装し複雑なタスクを解決するエージェントの構築。

-

オープンソース&プライバシーファースト設計:

- AGPL-3.0ライセンスでコード検査・改変・セルフホスティングが可能。

- ローカルファースト処理でデータプライバシーを確保。収集なし、テレメトリーなし、クラウドはオプトインのみ。

- モデルダウンロード後はオフライン動作もサポート。

-

デプロイの柔軟性:

- 最大限のプライバシーのためにローカル実行か、クラウドサービス(RunPod、Google Cloud、カスタムサーバー)へのデプロイが可能。

- ワンコマンド(

nodetool deploy)でインフラストラクチャのプロビジョニング、モデルダウンロード、コンテナ設定を自動化。 - ゼロスケール対応で、稼働中のみ推論料金が発生。

-

ユニバーサルモデルサポート:

- ローカル推論:

- MLX(Apple Silicon最適化、LLM・音声・画像生成対応)。

- Ollama(ローカルLLMの簡単セットアップ)。

- llama.cpp(CPU/GPU対応のクロスプラットフォームGGUFモデル推論)。

- vLLM(PagedAttentionを用いた本番品質サービス)。

- Nunchaku(Flux、Qwen、SDXL向け高性能推論)。

- クラウドプロバイダー:

- OpenAI、Anthropic、Gemini、OpenRouter、Cerebras、Minimax、HuggingFace、Fal AI、Replicate、Kie.aiのAPIキー直接連携。

- 複数プロバイダーを1つのワークフロー内で組み合わせ可能。

- モデル管理: アプリ内でHuggingFace Hubからモデルウェイトの検索、ダウンロード、管理が可能。

- ローカル推論:

-

多モーダル対応:

テキスト、画像、音声、動画をひとつのワークフローで処理可能。 -

豊富な構築要素:

AIモデル、データ処理、ファイル操作、計算、制御など1000以上の即利用コンポーネントを提供。 -

チャットアシスタント:

自然な会話を通じてワークフローと対話し、実行可能。 -

内蔵アセットマネージャー:

画像、音声、動画、ドキュメント(PNG, JPG, GIF, SVG, WebP, MP3, WAV, MP4, MOV, AVI, PDF, TXT, JSON, CSV, DOCX)を一元管理。

ユーザーのメリット

- アクセスの容易さ: コーディング不要で複雑なAIワークフローを構築可能。高度なAI技術の敷居を下げる。

- 透明性&デバッグ性: リアルタイム実行とステップ検査で完全な可視化と信頼を提供。

- プライバシー&コントロール: データとモデルをローカルに保持し、最大限のプライバシーと所有権を確保。

- 柔軟性: ローカルまたはクラウドでワークフローを実行し、多彩なモデルを活用可能。

- コスト効率: ローカル推論でクラウドコストを削減し、稼働中のみの利用料金でスケール可能。

- 多用途性: エージェントやRAGからクリエイティブパイプライン、データ処理まで幅広いAIアプリを創出可能。

- コミュニティサポート: オープンソースによりコミュニティ貢献、共有ワークフロー、開発者直接アクセスが促進。

対応環境と連携

- 対応OS: macOS、Windows、Linux。

- ハードウェア要件: Nvidia GPU または Apple Silicon M1以上、モデルダウンロード用に最低20GBの空き容量。

- クラウドデプロイ: RunPod、Google Cloud、カスタムサーバー対応。

- API連携: OpenAI、Anthropic、Gemini、OpenRouter、Cerebras、Minimax、HuggingFace、Fal AI、Replicate、Kie.ai。

- ローカルモデル対応: MLX、Ollama、llama.cpp、vLLM、Nunchaku。

入手および起動方法

- ダウンロード: macOS、Windows、Linux向けに公式サイトから直接ダウンロード可能。

- オープンソース: AGPL-3.0ライセンスのもとで、ユーザーはコード全体の検査、改変、セルフホスティングが可能。

![Deepfakes Web | Make Your Own Deepfake! [Online App]](https://img.tap4.ai/tools/2024/6/16/deepfakesweb-com-thumbnail-1718526608.png)