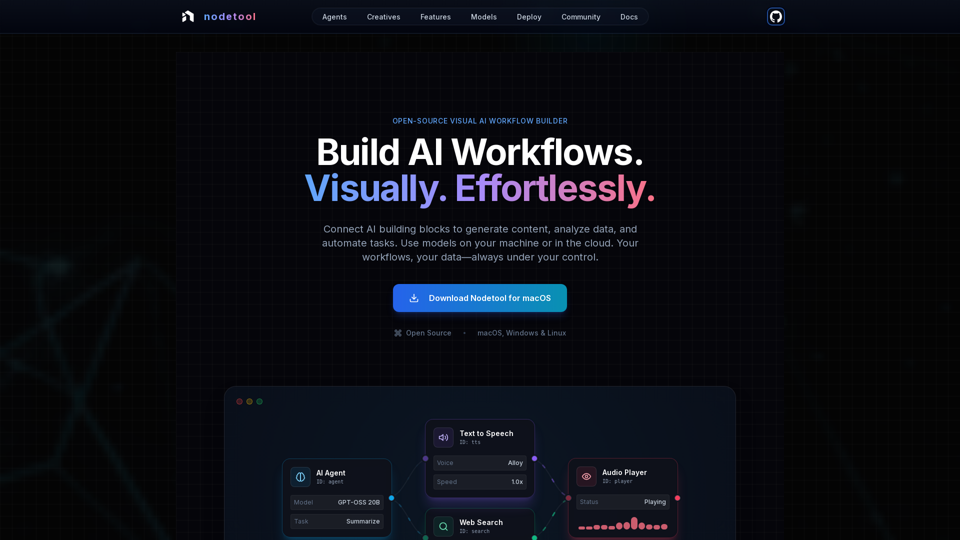

Recursos do Produto do Nodetool AI

Visão Geral

Nodetool AI é um construtor de fluxos de trabalho visuais de IA open-source, com prioridade local, para criar agentes avançados de LLM, pipelines RAG e fluxos de dados multimodais. Combina interfaces baseadas em nós com poderosas capacidades de automação, especificamente adaptadas para tarefas de IA, enfatizando privacidade, execução local e controle do usuário.

Propósito Principal e Grupo-Alvo

- Propósito Principal: Oferecer uma plataforma unificada, visual e sem código para construir, executar e implantar fluxos de trabalho complexos de IA, desde IA generativa e pipelines de mídia até agentes autônomos e inteligência documental.

- Grupo-Alvo: Desenvolvedores de IA, cientistas de dados, pesquisadores, criativos e qualquer pessoa que deseje criar e automatizar aplicações de IA sem programação extensiva, com forte preferência por privacidade, controle local e soluções open-source.

Detalhes e Operações das Funções

-

Automação Visual de Fluxos de Trabalho:

- Canvas de arrastar e soltar para orquestrar LLMs, ferramentas de dados e APIs.

- Conexões tipo-seguras garantem a integridade do fluxo de trabalho.

- Monitoramento em tempo real da execução e inspeção passo a passo para transparência e depuração.

-

IA Generativa e Pipelines de Mídia:

- Conecte nós para geração de vídeo, análise de texto, criação de imagens e processamento multimodal.

- Suporta modelos como Flux, SDXL, OpenAI Sora, Google Veo e modelos customizados.

-

RAG Local-First e Bancos de Dados Vetoriais:

- Indexe documentos e construa pipelines de busca semântica inteiramente na máquina local.

- ChromaDB integrado para RAG.

-

Agentes Autônomos de IA:

- Crie agentes capazes de buscar na web, navegar, usar ferramentas e sistemas multiagentes para solução de tarefas complexas.

-

Arquitetura Open Source e Prioridade à Privacidade:

- Licenciado AGPL-3.0, permitindo inspeção, modificação e auto-hospedagem.

- Processamento local-first garante privacidade dos dados; sem coleta, sem telemetria, cloud opcional por escolha.

- Suporta operação offline após download dos modelos.

-

Flexibilidade de Implantação:

- Execute fluxos localmente para máxima privacidade ou implante em serviços de nuvem (RunPod, Google Cloud, servidores customizados).

- Implantação com um comando (

nodetool deploy) para provisionar infraestrutura, baixar modelos e configurar containers. - Escalabilidade zero, pagando somente pelo tempo de inferência ativo.

-

Suporte Universal a Modelos:

- Inferência Local:

- MLX (otimizado para Apple Silicon em LLMs, áudio e geração de imagens).

- Ollama (configuração fácil para LLMs locais).

- llama.cpp (inferência de modelos GGUF multiplataforma em CPU/GPU).

- vLLM (serviço de nível produtivo com PagedAttention).

- Nunchaku (alto desempenho para Flux, Qwen, SDXL).

- Provedores de Nuvem:

- Integração direta via API key para OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai.

- Misture e combine provedores dentro de um único fluxo de trabalho.

- Gerenciamento de Modelos: Pesquise, baixe e gerencie pesos de modelos do HuggingFace Hub diretamente no app.

- Inferência Local:

-

Capacidades Multimodais:

Processe texto, imagem, áudio e vídeo dentro de um único fluxo de trabalho. -

Blocos de Construção Extensos:

Mais de 1000 componentes prontos para uso em modelos de IA, processamento de dados, operações de arquivos, computação, controle e mais. -

Assistente de Chat:

Interaja e execute fluxos de trabalho por meio de conversação natural. -

Gerenciador de Ativos Integrado:

Gestão centralizada para imagens, áudios, vídeos, documentos (PNG, JPG, GIF, SVG, WebP, MP3, WAV, MP4, MOV, AVI, PDF, TXT, JSON, CSV, DOCX).

Benefícios ao Usuário

- Acessibilidade: Crie fluxos de trabalho complexos de IA sem programação, tornando IA avançada acessível a todos.

- Transparência e Depuração: Execução em tempo real e inspeção passo a passo oferecem total visibilidade e confiança na operação dos fluxos.

- Privacidade e Controle: Mantenha dados e modelos localmente, garantindo máxima privacidade e propriedade.

- Flexibilidade: Execute fluxos localmente ou implante na nuvem, usando uma ampla variedade de modelos locais e em nuvem.

- Custo-Efetividade: Aproveite a inferência local para reduzir custos de nuvem e escale para zero em fluxos implantados.

- Versatilidade: Crie uma ampla gama de aplicações de IA, desde agentes e RAG até pipelines criativos e processamento de dados.

- Suporte Comunitário: Natureza open-source promove contribuições da comunidade, compartilhamento de fluxos e acesso direto aos desenvolvedores.

Compatibilidade e Integração

- Sistemas Operacionais: macOS, Windows, Linux.

- Requisitos de Hardware: GPU Nvidia ou Apple Silicon M1+ e pelo menos 20GB de espaço livre para download dos modelos.

- Implantação em Nuvem: RunPod, Google Cloud e servidores customizados.

- Integrações via API: OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai.

- Suporte a Modelos Locais: MLX, Ollama, llama.cpp, vLLM, Nunchaku.

Método de Acesso e Ativação

- Download: Disponível para download direto em macOS, Windows e Linux pelo site oficial.

- Código Aberto: Usuários podem inspecionar, modificar e auto-hospedar toda a stack, pois é open-source sob AGPL-3.0.