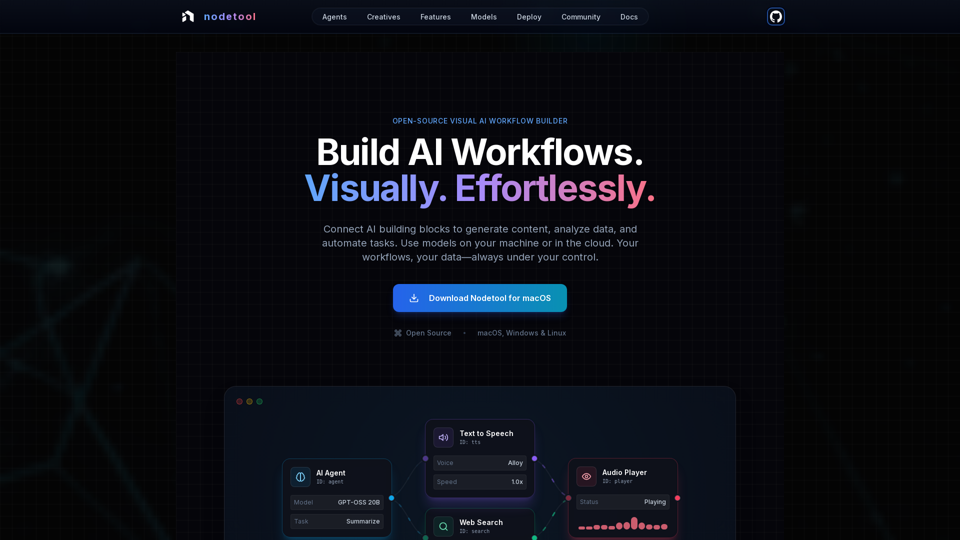

Nodetool AI 的產品特點

概述

Nodetool AI 是一款開源、以本地為先的視覺化 AI 工作流程構建工具,用於創建先進的 LLM 代理、RAG 管道和多模態數據流。它結合了節點式介面與強大的自動化功能,專為 AI 任務設計,強調隱私、本地執行與用戶掌控。

主要目的與目標用戶群

- 主要目的: 提供一個統一的、視覺化且免編碼的平台,用於構建、運行及部署複雜的 AI 工作流程,涵蓋生成式 AI、媒體管線、自主代理和文件智慧等多種應用。

- 目標用戶群: AI 開發者、數據科學家、研究人員、創意工作者,以及任何希望在無須大量編碼的情況下構建並自動化 AI 應用的人,尤其偏好隱私保護、本地掌控與開源方案的用戶。

功能詳情與操作

-

視覺化工作流程自動化:

- 拖放式畫布,用於協調 LLM、數據工具和 API。

- 型別安全連接,確保工作流程完整性。

- 實時執行監控與逐步檢視,增強透明度和調試能力。

-

生成式 AI 與媒體管線:

- 連接節點以生成視頻、文本分析、圖像創建和多模態處理。

- 支援 Flux、SDXL、OpenAI Sora、Google Veo 及自訂模型。

-

本地優先的 RAG 與向量資料庫:

- 在本地機器完成文檔索引與語義搜索管線構建。

- 集成 ChromaDB 用於 RAG。

-

自主 AI 代理:

- 建立具備網路搜尋、瀏覽、工具使用及多代理系統能力,解決複雜任務。

-

開源與隱私優先架構:

- 採用 AGPL-3.0 授權,允許檢視、修改與自我托管。

- 本地優先處理,保障數據隱私;無數據收集、無遙測,僅雲端選擇性啟用。

- 模型下載後支持離線運行。

-

部署靈活性:

- 可本地運行工作流程,確保最大隱私,或部署至雲端服務(RunPod、Google Cloud、自訂伺服器)。

- 一鍵部署命令(

nodetool deploy)自動配置基礎設施、下載模型與容器設定。 - 支援按需彈性擴展,僅為推理時間付費。

-

通用模型支持:

- 本地推理:

- MLX(針對 Apple Silicon 優化,應用於 LLM、音頻及圖像生成)。

- Ollama(本地 LLM 簡易設定)。

- llama.cpp(跨平台 GGUF 模型在 CPU/GPU 上推理)。

- vLLM(具 PagedAttention 的生產級服務器)。

- Nunchaku(支援 Flux、Qwen、SDXL 的高效能推理)。

- 雲端供應商:

- 直接 API 金鑰整合 OpenAI、Anthropic、Gemini、OpenRouter、Cerebras、Minimax、HuggingFace、Fal AI、Replicate、Kie.ai。

- 可在單一工作流程中混合多家供應商。

- 模型管理: 於應用內直接搜尋、下載並管理 HuggingFace Hub 上的模型權重。

- 本地推理:

-

多模態能力:

在單一工作流程中處理文本、圖像、音頻及視頻。 -

豐富組件庫:

超過 1000 個現成元件,涵蓋 AI 模型、數據處理、文件操作、計算及控制等。 -

聊天助手:

透過自然對話方式進行互動與工作流程運行。 -

內建資產管理器:

集中管理圖像、音頻、視頻、文件(PNG、JPG、GIF、SVG、WebP、MP3、WAV、MP4、MOV、AVI、PDF、TXT、JSON、CSV、DOCX)。

用戶收益

- 易用性: 免編碼即可創建複雜 AI 工作流程,讓先進 AI 更為親民。

- 透明性與調試性: 實時執行與逐步檢視,提供完全可視化和執行信心。

- 隱私與掌控: 數據與模型皆保留於本地,保障最大隱私與所有權。

- 彈性: 本地運行或雲端部署,靈活運用多種本地及雲端模型。

- 成本效益: 利用本地推理降低雲端成本,部署工作流程可隨需擴展至零。

- 多功能性: 可構建各類 AI 應用,涵蓋代理、RAG、創意管線與數據處理。

- 社群支持: 開源特性促進社群貢獻、共享工作流程及與開發者直接互動。

相容性與整合

- 作業系統: macOS、Windows、Linux。

- 硬體需求: Nvidia GPU 或 Apple Silicon M1 以上,及至少 20GB 空間供模型下載。

- 雲端部署: RunPod、Google Cloud 及自訂伺服器。

- API 整合: OpenAI、Anthropic、Gemini、OpenRouter、Cerebras、Minimax、HuggingFace、Fal AI、Replicate、Kie.ai。

- 本地模型支持: MLX、Ollama、llama.cpp、vLLM、Nunchaku。

取得與啟用方式

- 下載: 官方網站提供 macOS、Windows 和 Linux 版本直接下載。

- 開源: 依 AGPL-3 授權,使用者可檢視、修改並自我托管完整系統。