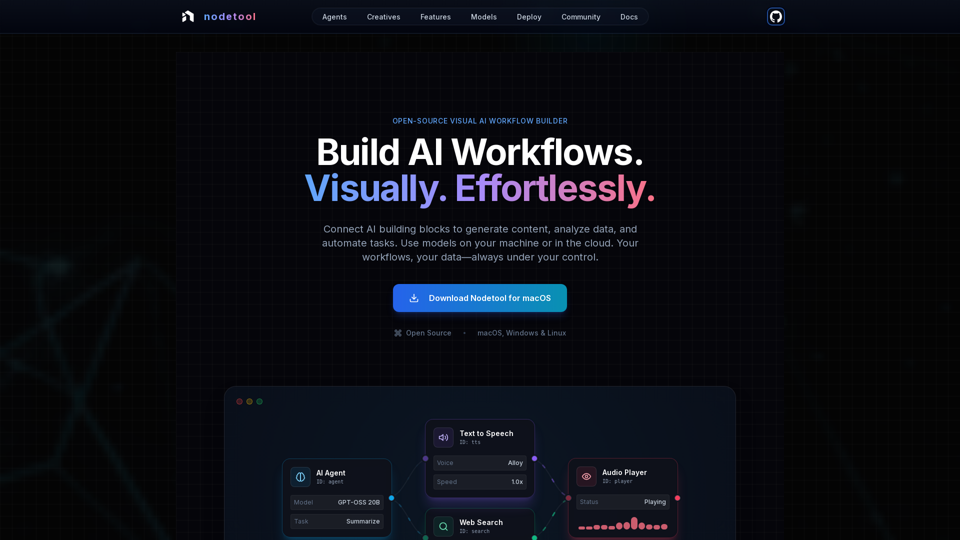

Tính Năng Sản Phẩm của Nodetool AI

Tổng Quan

Nodetool AI là công cụ xây dựng workflow AI trực quan, ưu tiên chạy trên thiết bị địa phương, mã nguồn mở, giúp tạo ra các agent LLM nâng cao, pipeline RAG và luồng dữ liệu đa phương thức. Nodetool kết hợp giao diện dựa trên node với khả năng tự động hóa mạnh mẽ, được thiết kế riêng cho các tác vụ AI, nhấn mạnh về quyền riêng tư, thực thi cục bộ và kiểm soát người dùng.

Mục Đích Chính và Nhóm Người Dùng Mục Tiêu

- Mục Đích Chính: Cung cấp nền tảng trực quan, không cần mã hóa, thống nhất để xây dựng, vận hành và triển khai các workflow AI phức tạp, từ AI tạo sinh, pipeline truyền thông đến agent tự động và trí tuệ tài liệu.

- Nhóm Người Dùng Mục Tiêu: Lập trình viên AI, nhà khoa học dữ liệu, nhà nghiên cứu, người sáng tạo và bất kỳ ai muốn xây dựng và tự động hóa ứng dụng AI mà không cần nhiều mã hóa, ưu tiên cao về quyền riêng tư, kiểm soát cục bộ và giải pháp mã nguồn mở.

Chi Tiết Chức Năng và Hoạt Động

-

Tự Động Hóa Workflow Trực Quan:

- Màn hình kéo thả để điều phối LLM, công cụ dữ liệu và API.

- Kết nối an toàn kiểu đảm bảo tính toàn vẹn của workflow.

- Giám sát thực thi theo thời gian thực và kiểm tra từng bước để minh bạch và gỡ lỗi.

-

Pipeline AI Tạo Sinh & Truyền Thông:

- Kết nối các node cho tạo video, phân tích văn bản, tạo hình ảnh và xử lý đa phương thức.

- Hỗ trợ các mô hình như Flux, SDXL, OpenAI Sora, Google Veo và mô hình tùy chỉnh.

-

RAG & Vector DB Ưu Tiên Cục Bộ:

- Lập chỉ mục tài liệu và xây dựng pipeline tìm kiếm ngữ nghĩa hoàn toàn trên máy cục bộ.

- Tích hợp ChromaDB cho RAG.

-

Agent AI Tự Động:

- Xây dựng agent có khả năng tìm kiếm web, duyệt web, sử dụng công cụ và hệ thống đa agent để giải quyết các tác vụ phức tạp.

-

Kiến Trúc Mở Nguồn & Ưu Tiên Quyền Riêng Tư:

- Giấy phép AGPL-3.0, cho phép người dùng kiểm tra, chỉnh sửa và tự host.

- Xử lý ưu tiên cục bộ đảm bảo quyền riêng tư dữ liệu; không thu thập thông tin, không có telemetry, chỉ sử dụng đám mây khi người dùng đồng ý.

- Hỗ trợ vận hành offline sau khi tải mô hình về.

-

Linh Hoạt Triển Khai:

- Chạy workflow cục bộ để tối đa bảo mật, hoặc triển khai lên các dịch vụ đám mây (RunPod, Google Cloud, server tùy chỉnh).

- Triển khai bằng một lệnh duy nhất (

nodetool deploy) để thiết lập hạ tầng, tải mô hình và cấu hình container. - Tự động mở rộng đến số 0, chỉ tính phí khi inference hoạt động.

-

Hỗ Trợ Mô Hình Toàn Diện:

- Inference Cục Bộ:

- MLX (tối ưu cho Apple Silicon, dành cho LLM, âm thanh, tạo hình ảnh).

- Ollama (dễ dàng thiết lập LLM cục bộ).

- llama.cpp (inference mô hình GGUF đa nền tảng trên CPU/GPU).

- vLLM (dịch vụ sản xuất với PagedAttention).

- Nunchaku (hiệu năng cao cho Flux, Qwen, SDXL).

- Nhà Cung Cấp Đám Mây:

- Tích hợp API key trực tiếp cho OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai.

- Kết hợp linh hoạt nhà cung cấp trong một workflow duy nhất.

- Quản Lý Mô Hình: Tìm kiếm, tải và quản lý trọng số mô hình từ HuggingFace Hub trực tiếp trong ứng dụng.

- Inference Cục Bộ:

-

Khả Năng Đa Phương Thức:

Xử lý văn bản, hình ảnh, âm thanh và video trong cùng một workflow. -

Khối Lắp Ráp Phong Phú:

Hơn 1000 thành phần sẵn dùng cho mô hình AI, xử lý dữ liệu, thao tác file, tính toán, kiểm soát và nhiều hơn nữa. -

Trợ Lý Chat:

Tương tác và chạy workflow qua hội thoại tự nhiên. -

Quản Lý Tài Sản Tích Hợp:

Quản lý tập trung hình ảnh, âm thanh, video, tài liệu (PNG, JPG, GIF, SVG, WebP, MP3, WAV, MP4, MOV, AVI, PDF, TXT, JSON, CSV, DOCX).

Lợi Ích Cho Người Dùng

- Truy Cập Dễ Dàng: Xây dựng workflow AI phức tạp không cần mã hóa, giúp AI nâng cao dễ tiếp cận với mọi người.

- Minh Bạch & Dễ Gỡ Lỗi: Thực thi thời gian thực và kiểm tra từng bước đảm bảo quan sát đầy đủ và tin cậy trong hoạt động workflow.

- Quyền Riêng Tư & Kiểm Soát: Giữ dữ liệu và mô hình cục bộ, đảm bảo quyền riêng tư và sở hữu tối ưu.

- Linh Hoạt: Chạy workflow cục bộ hoặc triển khai đám mây, sử dụng nhiều mô hình cả cục bộ và đám mây.

- Tiết Kiệm Chi Phí: Tận dụng inference cục bộ để giảm chi phí đám mây và mở rộng đến số 0 cho workflow triển khai.

- Đa Dạng Ứng Dụng: Tạo ra đa dạng ứng dụng AI, từ agent, RAG đến pipeline sáng tạo và xử lý dữ liệu.

- Hỗ Trợ Cộng Đồng: Tính chất mã nguồn mở khuyến khích đóng góp của cộng đồng, chia sẻ workflow và truy cập trực tiếp tới nhà phát triển.

Tương Thích và Tích Hợp

- Hệ Điều Hành: macOS, Windows, Linux.

- Yêu Cầu Phần Cứng: GPU Nvidia hoặc Apple Silicon M1+ và ít nhất 20GB dung lượng trống để tải mô hình.

- Triển Khai Đám Mây: RunPod, Google Cloud và server tùy chỉnh.

- Tích Hợp API: OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai.

- Hỗ Trợ Mô Hình Cục Bộ: MLX, Ollama, llama.cpp, vLLM, Nunchaku.

Phương Thức Truy Cập và Kích Hoạt

- Tải Về: Có sẵn tải trực tiếp trên macOS, Windows và Linux từ website chính thức.

- Mã Nguồn Mở: Người dùng có thể kiểm tra, chỉnh sửa và tự host toàn bộ nền tảng vì là mã nguồn mở theo giấy phép AGPL-3.0.