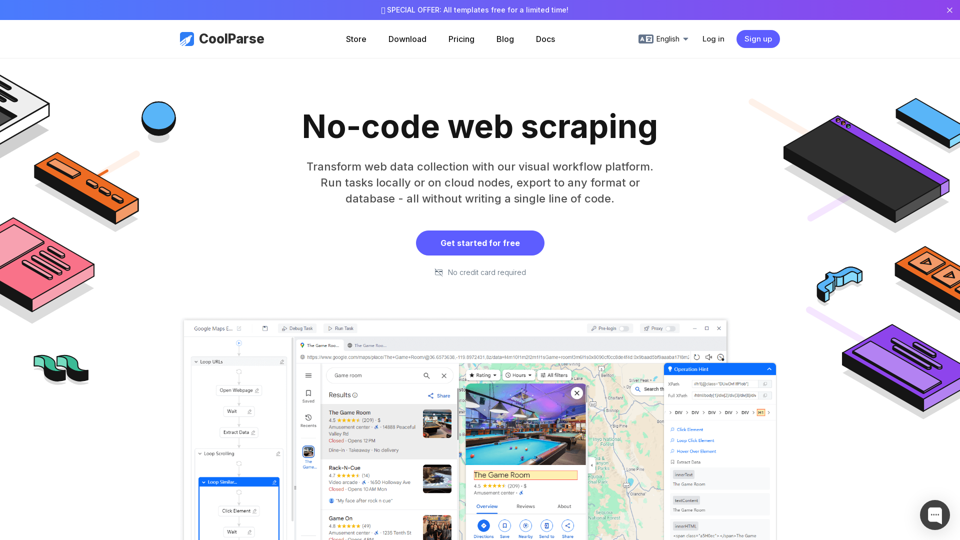

Propósito Principal y Grupo Objetivo de Usuarios

- Propósito: Simplificar el scraping web y automatizar la extracción de datos de websites.

- Usuarios Objetivo:

- Analistas de datos

- Gerentes de comercio electrónico

- Investigadores de mercado

- Especialistas en SEO

- Emprendedores y propietarios de pequeñas empresas

- Ingenieros de software

Detalles de Función y Operaciones

Características Principales

-

Constructor de Tareas Visual sin Código

- Interfaz de arrastrar y soltar para crear flujos de trabajo de scraping.

- Reconocimiento inteligente de patrones para la generación automática de reglas de extracción.

-

Plantillas de Scraping Preconfiguradas

- Plantillas listas para usar para Google Maps, Google Search, Amazon y más.

- Parámetros personalizables (palabras clave, ubicaciones, paginación).

-

Scraping Inteligente y de Alta Velocidad

- Tecnología de Doble Motor para solicitudes concurrentes.

- Detección automática de elementos de página con sugerencias de XPath.

-

Procesamiento y Exportación de Datos

- Más de 18 técnicas de limpieza de datos (filtrado, formateo, deduplicación).

- Exportación a 7 formatos de archivo (Excel, CSV, JSON, XML, etc.).

- Integración directa con bases de datos (MySQL, PostgreSQL, MongoDB, etc.).

-

Gestión de Tareas y Automatización

- Scraping programado para actualizaciones continuas de datos.

- Puntos de control de auto-guardado para reanudar tareas interrumpidas.

-

Evasión de Bloqueos Anti-Scraping

- Simula comportamiento humano para evitar bloqueos de IP.

- Soporta proxies y ajustes de limitación de tasa.

Herramientas Adicionales

- Soporte multilingüe (inglés, chino, español, etc.).

- Kit de herramientas utilitarias (validación MD5/Hash, codificación Base64, codificación URL).

Beneficios para el Usuario

- Ahorro de Tiempo: Reduce la colección manual de datos en un 90%.

- Precisión: Garantiza la captura del 100% de los datos con un procesamiento inteligente.

- Facilidad de Uso: No requiere codificación—ideal para usuarios sin conocimientos técnicos.

- Escalabilidad: Ejecución en la nube para scraping a gran escala.

- Rentabilidad: Elimina la necesidad de desarrollos a medida o costos de API.

Compatibilidad e Integración

- Sitios Web Soportados: Funciona con cualquier sitio web, incluyendo páginas dinámicas pesadas en JS.

- Soporte de Bases de Datos: MySQL, PostgreSQL, Oracle, MongoDB y más.

- Formatos de Archivo: Excel, CSV, JSON, XML, TXT, YAML, HTML.

- Sistemas Operativos: Windows, macOS, Linux (vía nodos en la nube).

Comentarios de Clientes y Estudios de Caso

- Jennifer Wilson (Analista de Datos): "Mejoró la eficiencia en un 50% gracias al scraping automatizado."

- Michael Zhang (Gerente de Comercio Electrónico): "Un cambio total para la extracción de datos de productos."

- Emma Watson (Investigadora de Mercado): "El scraping programado es perfecto para el monitoreo en tiempo real."

- David Park (Ingeniero de Software): "Las mejores estrategias anti-scraping—rara vez enfrentamos bloqueos de IP."

Método de Acceso y Activación

- Prueba Gratuita: Prueba premium de 14 días (no se requiere tarjeta de crédito).

- Planes de Precios: Suscripciones flexibles para individuos y empresas.

- Descarga y Uso en la Nube: Disponible para ejecución local o en la nube.

- Configuración Instantánea: Regístrate en CoolParse.com.

CoolParse habilita a los usuarios a extraer, procesar y utilizar datos web de manera sencilla, convirtiéndose en la mejor opción para negocios y profesionales en el área del analizador, extracción, datos y web. 🚀