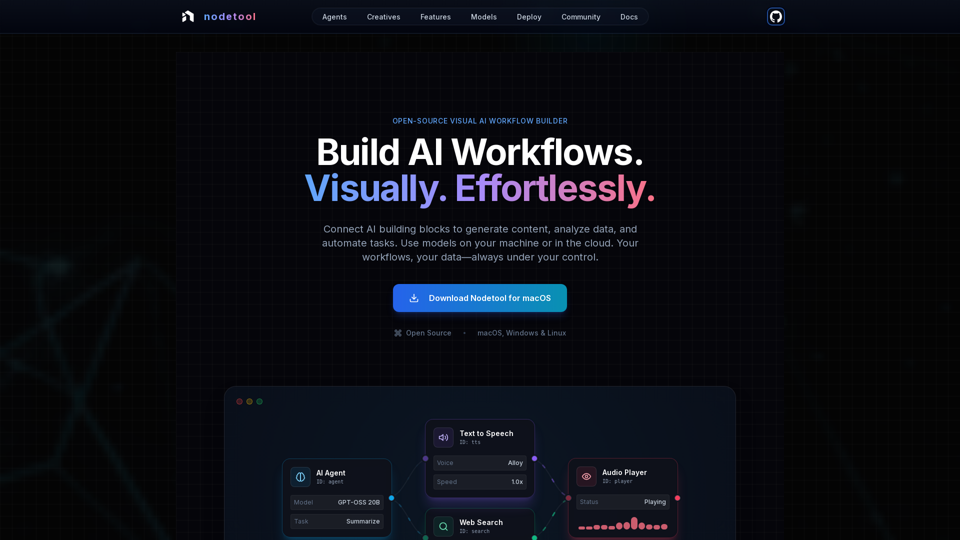

Características del Producto de Nodetool AI

Resumen

Nodetool AI es una herramienta visual de IA local y de código abierto para crear agentes avanzados LLM, pipelines RAG y flujos de datos multimodales. Combina interfaces basadas en nodos con potentes capacidades de automatización, específicamente diseñadas para tareas de IA, enfatizando la privacidad, la ejecución local y el control del usuario.

Propósito Principal y Grupo de Usuarios Objetivo

- Propósito Principal: Proporcionar una plataforma unificada, visual y sin código para construir, ejecutar y desplegar complejos flujos de trabajo de IA, desde IA generativa y pipelines multimedia hasta agentes autónomos e inteligencia documental.

- Grupo de Usuarios Objetivo: Desarrolladores de IA, científicos de datos, investigadores, creativos y cualquier persona que busque construir y automatizar aplicaciones de IA sin necesidad de programación extensa, con una fuerte preferencia por la privacidad, el control local y soluciones de código abierto.

Detalles de Función y Operaciones

-

Automatización Visual de Flujos de Trabajo:

- Lienzo de arrastrar y soltar para orquestar LLMs, herramientas de datos y APIs.

- Conexiones tipadas que garantizan la integridad del flujo de trabajo.

- Monitoreo de ejecución en tiempo real e inspección paso a paso para mayor transparencia y depuración.

-

IA Generativa y Pipelines Multimedia:

- Conecta nodos para generación de video, análisis de texto, creación de imágenes y procesamiento multimodal.

- Soporta modelos como Flux, SDXL, OpenAI Sora, Google Veo y modelos personalizados.

-

RAG Local-First y Bases de Datos Vectoriales:

- Indexa documentos y construye pipelines de búsqueda semántica completamente en la máquina local.

- ChromaDB integrado para RAG.

-

Agentes Autónomos de IA:

- Construye agentes capaces de búsqueda web, navegación, uso de herramientas y sistemas multi-agente para resolver tareas complejas.

-

Arquitectura Abierta y Prioridad en la Privacidad:

- Licenciado bajo AGPL-3.0, permitiendo inspección, modificación y auto-hosting.

- Procesamiento local-first para asegurar la privacidad de datos; sin recolección, sin telemetría, nube solo si se opta voluntariamente.

- Soporta operación sin conexión una vez descargados los modelos.

-

Flexibilidad de Despliegue:

- Ejecuta workflows localmente para máxima privacidad o despliega en servicios en la nube (RunPod, Google Cloud, servidores personalizados).

- Despliegue con un solo comando (

nodetool deploy) para provisionar infraestructura, descargar modelos y configurar contenedores. - Escalado a cero, pagando solo por tiempo activo de inferencia.

-

Soporte Universal de Modelos:

- Inferencia Local:

- MLX (optimizado para Apple Silicon para LLMs, audio e imagen).

- Ollama (configuración sencilla para LLMs locales).

- llama.cpp (inferencia multiplataforma de modelos GGUF en CPU/GPU).

- vLLM (servicio de producción con PagedAttention).

- Nunchaku (alto rendimiento para Flux, Qwen, SDXL).

- Proveedores en la Nube:

- Integración directa de claves API para OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai.

- Mezcla y combinación de proveedores dentro de un mismo flujo de trabajo.

- Gestión de Modelos: Búsqueda, descarga y gestión de pesos de modelos desde HuggingFace Hub directamente en la aplicación.

- Inferencia Local:

-

Capacidades Multimodales:

Procesa texto, imagen, audio y video dentro de un mismo flujo de trabajo. -

Bloques de Construcción Extensos:

Más de 1000 componentes listos para usar para modelos de IA, procesamiento de datos, operaciones de archivos, cálculo, control y más. -

Asistente de Chat:

Interactúa y ejecuta workflows mediante conversación natural. -

Gestor de Activos Integrado:

Administración centralizada para imágenes, audio, video y documentos (PNG, JPG, GIF, SVG, WebP, MP3, WAV, MP4, MOV, AVI, PDF, TXT, JSON, CSV, DOCX).

Beneficios para el Usuario

- Accesibilidad: Construye complejos flujos de trabajo de IA sin codificar, haciendo la IA avanzada accesible para todos.

- Transparencia y Depuración: Ejecución en tiempo real e inspección paso a paso ofrecen visibilidad total y confianza en la operación del workflow.

- Privacidad y Control: Mantén datos y modelos de forma local, asegurando máxima privacidad y propiedad.

- Flexibilidad: Ejecuta workflows localmente o despliega en la nube, usando una amplia gama de modelos locales y en nube.

- Eficiencia de Costos: Aprovecha la inferencia local para reducir costos en la nube y escalado a cero para workflows desplegados.

- Versatilidad: Crea una amplia gama de aplicaciones de IA, desde agentes y RAG hasta pipelines creativos y procesamiento de datos.

- Soporte Comunitario: La naturaleza open-source fomenta contribuciones de la comunidad, workflows compartidos y acceso directo a desarrolladores.

Compatibilidad e Integración

- Sistemas Operativos: macOS, Windows, Linux.

- Requisitos de Hardware: GPU Nvidia o Apple Silicon M1+ y al menos 20 GB de espacio libre para descargas de modelos.

- Despliegue en la Nube: RunPod, Google Cloud y servidores personalizados.

- Integraciones API: OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai.

- Soporte de Modelos Locales: MLX, Ollama, llama.cpp, vLLM, Nunchaku.

Método de Acceso y Activación

- Descarga: Disponible para descarga directa en macOS, Windows y Linux desde el sitio web oficial.

- Open Source: Los usuarios pueden inspeccionar, modificar y auto-hospedar toda la plataforma, ya que es open-source bajo licencia AGPL-3.0.