Nodetool AI의 제품 특징

개요

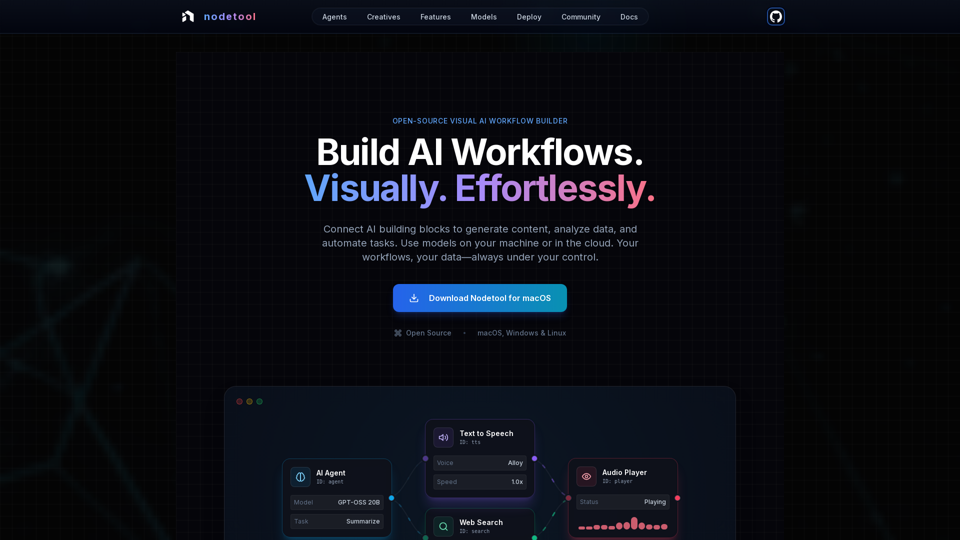

Nodetool AI는 고급 LLM 에이전트, RAG 파이프라인, 멀티모달 데이터 흐름을 만들기 위한 오픈소스 로컬 퍼스트 시각적 AI 워크플로우 빌더입니다. 노드 기반 인터페이스와 강력한 자동화 기능을 결합하여 AI 작업에 최적화되었으며, 프라이버시, 로컬 실행, 사용자 제어에 중점을 둡니다.

주요 목적 및 대상 사용자

- 주요 목적: 생성 AI, 미디어 파이프라인부터 자율 에이전트, 문서 인텔리전스까지 복잡한 AI 워크플로우를 코드 없이 시각적으로 구축, 실행, 배포할 수 있는 통합 플랫폼 제공

- 대상 사용자: AI 개발자, 데이터 과학자, 연구원, 크리에이티브, 복잡한 코딩 없이 AI 애플리케이션을 만들고 자동화하려는 사람들, 특히 프라이버시와 로컬 제어, 오픈소스 솔루션을 선호하는 사용자

기능 세부사항 및 운영

-

시각적 워크플로우 자동화:

- LLM, 데이터 도구, API를 오케스트레이션하는 드래그 앤 드롭 캔버스

- 타입 안정 연결로 워크플로우 무결성 보장

- 실시간 실행 모니터링 및 단계별 점검으로 투명성과 디버깅 지원

-

생성 AI 및 미디어 파이프라인:

- 비디오 생성, 텍스트 분석, 이미지 생성, 멀티모달 처리용 노드 연결

- Flux, SDXL, OpenAI Sora, Google Veo, 커스텀 모델 지원

-

로컬 퍼스트 RAG 및 벡터 DB:

- 문서 인덱싱 및 의미 검색 파이프라인 완전 로컬 구축

- 통합된 ChromaDB로 RAG 지원

-

자율 AI 에이전트:

- 웹 검색, 브라우징, 도구 사용, 복잡한 작업 해결 위한 멀티 에이전트 시스템 구축 가능

-

오픈소스 및 프라이버시 우선 아키텍처:

- AGPL-3.0 라이선스, 코드 검토, 수정, 자체 호스팅 가능

- 로컬 퍼스트 처리로 데이터 프라이버시 보장; 데이터 수집 없음, 텔레메트리 없음, 클라우드 선택적 사용

- 모델 다운로드 후 오프라인 실행 지원

-

배포 유연성:

- 최대 프라이버시를 위해 로컬 실행 또는 RunPod, Google Cloud, 커스텀 서버 등 클라우드 배포 가능

- 인프라 프로비저닝, 모델 다운로드, 컨테이너 구성의 원커맨드 배포(

nodetool deploy) - 워크플로우 비활성 시 비용 발생하지 않는 스케일 투 제로 지원

-

범용 모델 지원:

- 로컬 추론:

- MLX (Apple Silicon 최적화, LLM, 오디오, 이미지 생성)

- Ollama (로컬 LLM 간편 설정)

- llama.cpp (CPU/GPU 크로스플랫폼 GGUF 모델 추론)

- vLLM (PagedAttention 기반 프로덕션 서비스)

- Nunchaku (Flux, Qwen, SDXL 고성능 지원)

- 클라우드 공급자:

- OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai API 키 직접 통합

- 단일 워크플로우 내 공급자 혼합 사용 가능

- 모델 관리: 앱 내에서 HuggingFace Hub 모델 검색, 다운로드, 관리

- 로컬 추론:

-

멀티모달 기능:

텍스트, 이미지, 오디오, 비디오를 단일 워크플로우 내에서 처리 가능 -

풍부한 빌딩 블록 제공:

AI 모델, 데이터 처리, 파일 작업, 계산, 제어 등 1000개 이상의 즉시 사용 가능한 컴포넌트 -

채팅 어시스턴트:

자연어 대화로 워크플로우 실행 및 상호작용 가능 -

내장 에셋 관리자:

PNG, JPG, GIF, SVG, WebP, MP3, WAV, MP4, MOV, AVI, PDF, TXT, JSON, CSV, DOCX 포맷의 이미지, 오디오, 비디오, 문서 중앙 관리

사용자 혜택

- 접근성: 코딩 없이 복잡한 AI 워크플로우 구축, 고급 AI의 대중적 접근성 제공

- 투명성 및 디버깅 용이: 실시간 실행과 단계별 점검으로 워크플로우 완전 가시성 확보

- 프라이버시 및 제어: 데이터와 모델을 로컬에 보관해 최대한의 프라이버시와 소유권 보장

- 유연성: 로컬 또는 클라우드 실행 선택 가능, 다양한 로컬 및 클라우드 모델 활용

- 비용 효율성: 로컬 추론으로 클라우드 비용 절감, 비활성 워크플로우는 비용없이 자동 스케일링

- 다양성: 에이전트, RAG, 창작 파이프라인, 데이터 처리 등 다채로운 AI 애플리케이션 제작 가능

- 커뮤니티 지원: 오픈소스 특성상 커뮤니티 기여, 공유 워크플로우, 개발자 직접 접근 가능

호환성 및 통합

- 운영체제: macOS, Windows, Linux

- 하드웨어 요구사항: Nvidia GPU 또는 Apple Silicon M1 이상, 모델 다운로드용 최소 20GB 여유 공간

- 클라우드 배포: RunPod, Google Cloud, 커스텀 서버 지원

- API 통합: OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai

- 로컬 모델 지원: MLX, Ollama, llama.cpp, vLLM, Nunchaku

접근 및 활성화 방법

- 다운로드: 공식 웹사이트에서 macOS, Windows, Linux용 직접 다운로드 가능

- 오픈소스: AGPL-3.0 라이선스 하에 전체 스택 검토, 수정, 자체 호스팅 가능