Papers with Code란 무엇인가?

Papers with Code는 머신 러닝 분야의 최신 연구와 그 구현 코드를 강조하는 플랫폼입니다. 이는 연구자와 개발자가 최신 발전과 실용적인 구현을 파악하는 데 도움이 되는 종합적인 리소스로 작용합니다.

Papers with Code의 장점

- 최신 연구 접근: 머신 러닝의 최신 논문을 계속 업데이트합니다.

- 구현 준비 완료: 코드 구현에 직접 접근하여 실험과 학습을 용이하게 합니다.

- 벤치마킹: 다양한 작업에서 서로 다른 모델의 성능을 비교합니다.

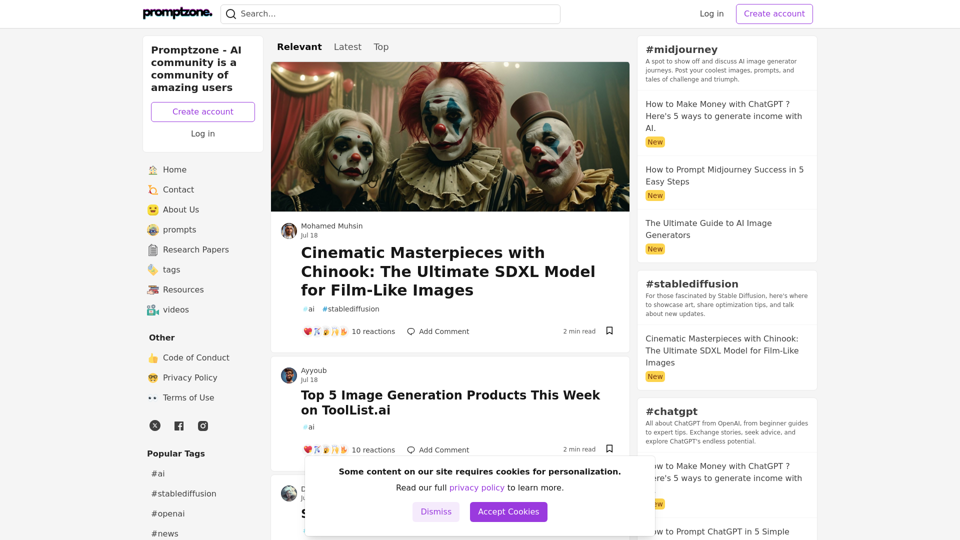

- 커뮤니티 참여: 연구자 및 개발자 커뮤니티와 통찰력과 개선 사항을 공유합니다.

Papers with Code 사용 방법

- 논문 탐색: 관련성과 영향력에 따라 정렬된 머신 러닝 논문 목록을 탐색합니다.

- 코드 접근: 연구의 코드 구현을 포함하는 저장소에 직접 접근합니다.

- 모델 벤치마킹: 표준 데이터셋과 작업 전반에 걸쳐 모델 성능을 보고 비교합니다.

- 기여: 개선 사항이나 새로운 구현을 커뮤니티와 공유합니다.

추천 논문

MossFormer: Monaural Speech Separation의 성능 한계 극복

- 설명: 컨볼루션이 강화된 공동 자기 주의 메커니즘을 사용하는 게이트 단일 헤드 트랜스포머로 음성 분리를 개선합니다.

- 코드 저장소: GitHub의

modelscope/ClearerVoice-Studio에서 이용 가능.

Gaze-LLE: 대규모 학습 인코더를 통한 시선 타겟 추정

- 설명: 학습된 인코더를 사용하여 장면 내 시선 타겟을 예측하는 데 중점을 둡니다.

- 코드 저장소: GitHub의

fkryan/gazelle에서 이용 가능.

Segment Any Text: 문장 분할을 위한 범용 접근법

- 설명: 강력하고 효율적인 문장 분할을 위한 SaT 모델을 소개합니다.

- 코드 저장소: GitHub의

facebookresearch/large_concept_model에서 이용 가능.

StableAnimator: 고품질 정체성 보존 인간 이미지 애니메이션

- 설명: 해밀턴-야코비-벨만 방정식 기반 최적화를 사용하여 애니메이션 중 얼굴 품질을 향상시킵니다.

- 코드 저장소: GitHub의

Francis-Rings/StableAnimator에서 이용 가능.

SynCamMaster: 멀티 카메라 비디오 생성 동기화

- 설명: 일관된 멀티 카메라 비디오 생성을 위한 비디오 확산 모델의 발전.

- 코드 저장소: GitHub의

kwaivgi/syncammaster에서 이용 가능.

주의를 위한 흐름 필드 학습으로 제어 가능한 인물 이미지 생성

- 설명: 모델 불가지론적 손실을 사용하여 확산 모델의 성능을 향상시킵니다.

- 코드 저장소: GitHub의

franciszzj/leffa에서 이용 가능.

연속 3D 인간 자세와 형태 추정을 위한 신경 로컬라이저 필드

- 설명: 단일 이미지 3D 인간 모델링을 데이터 중심 패러다임으로 전환합니다.

- 코드 저장소: GitHub의

isarandi/nlf에서 이용 가능.

Video Seal: 개방적이고 효율적인 비디오 워터마킹

- 설명: 신경 비디오 워터마킹을 위한 프레임워크를 소개합니다.

- 코드 저장소: GitHub의

facebookresearch/videoseal에서 이용 가능.

HunyuanVideo: 대규모 비디오 생성 모델을 위한 체계적인 프레임워크

- 설명: 비디오 생성에서 높은 성능을 보여주는 오픈 소스 모델.

- 코드 저장소: GitHub의

tencent/hunyuanvideo에서 이용 가능.

LLMs-as-Judges: LLM 기반 평가 방법에 대한 종합 조사

- 설명: LLM 판사의 한계와 미래 방향을 분석합니다.

- 코드 저장소: GitHub의

cshaitao/awesome-llms-as-judges에서 이용 가능.