คุณสมบัติผลิตภัณฑ์ของ Nodetool AI

ภาพรวม

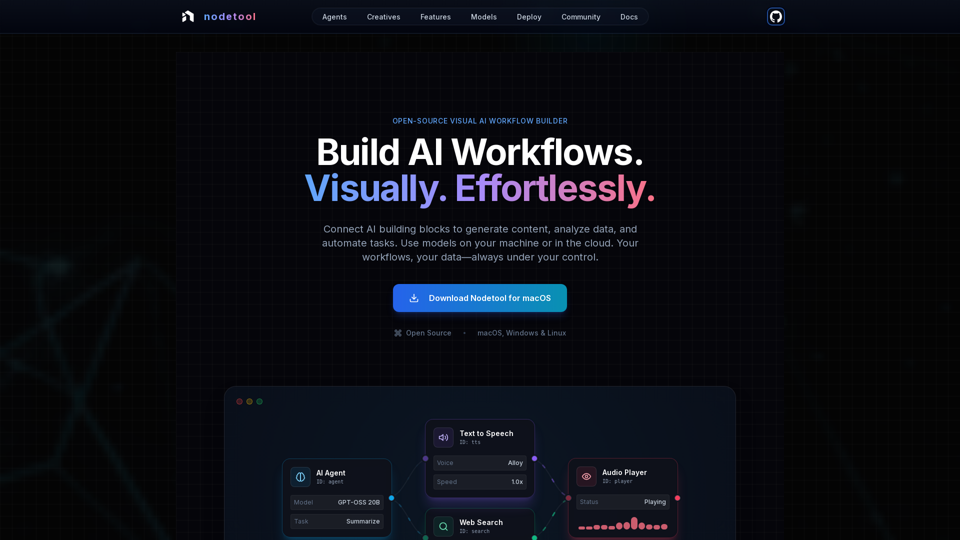

Nodetool AI คือเครื่องมือสร้างเวิร์กโฟลว์ AI แบบภาพที่เน้นการใช้งานในเครื่องและเป็นโอเพนซอร์ส สำหรับสร้างตัวแทน LLM ขั้นสูง, ท่อ RAG และการไหลของข้อมูลมัลติโหมด ผสานอินเทอร์เฟซแบบโหนดกับความสามารถอัตโนมัติที่ทรงพลัง โดยออกแบบเฉพาะสำหรับงาน AI โดยเน้นความเป็นส่วนตัว การประมวลผลในเครื่อง และการควบคุมของผู้ใช้

จุดประสงค์หลักและกลุ่มเป้าหมาย

- จุดประสงค์หลัก: เพื่อมอบแพลตฟอร์มเดียวที่เป็นภาพและไม่ต้องเขียนโค้ด สำหรับสร้าง รัน และปรับใช้เวิร์กโฟลว์ AI ที่ซับซ้อน ตั้งแต่ generative AI และท่อสื่อ ไปจนถึงตัวแทนอัตโนมัติและการวิเคราะห์เอกสาร

- กลุ่มเป้าหมาย: นักพัฒนา AI, นักวิทยาศาสตร์ข้อมูล, นักวิจัย, นักสร้างสรรค์ และทุกคนที่ต้องการสร้างและอัตโนมัติแอปพลิเคชัน AI โดยไม่จำเป็นต้องเขียนโค้ดยาก พร้อมกับเน้นความเป็นส่วนตัว การควบคุมในเครื่อง และโซลูชันแบบโอเพนซอร์ส

รายละเอียดฟังก์ชันและการทำงาน

-

การอัตโนมัติเวิร์กโฟลว์แบบภาพ:

- แคนวาสลากและวางสำหรับจัดการ LLMs, เครื่องมือข้อมูล และ API

- การเชื่อมต่อแบบ type-safe เพื่อความถูกต้องของเวิร์กโฟลว์

- การตรวจสอบการทำงานแบบเรียลไทม์ และการตรวจสอบทีละขั้นตอน เพื่อความโปร่งใสและช่วยดีบัก

-

Generative AI & ท่อสื่อ:

- เชื่อมต่อโหนดเพื่อสร้างวิดีโอ, วิเคราะห์ข้อความ, สร้างภาพ และประมวลผลมัลติโหมด

- รองรับโมเดล เช่น Flux, SDXL, OpenAI Sora, Google Veo และโมเดลที่กำหนดเอง

-

RAG & ฐานข้อมูลเวกเตอร์แบบ local-first:

- ทำดัชนีเอกสารและสร้างท่อการค้นหาเชิงความหมายทั้งหมดบนเครื่องท้องถิ่น

- รวม ChromaDB สำหรับ RAG

-

ตัวแทน AI อิสระ:

- สร้างตัวแทนที่สามารถค้นหาเว็บ, เลื่อนดู, ใช้เครื่องมือต่าง ๆ และระบบหลายตัวแทนสำหรับแก้ไขงานที่ซับซ้อน

-

สถาปัตยกรรมแบบโอเพนซอร์สและเน้นความเป็นส่วนตัว:

- ใบอนุญาต AGPL-3.0 เปิดให้ตรวจสอบ แก้ไข และโฮสต์เองได้

- ประมวลผลในเครื่องเพื่อความเป็นส่วนตัวสูงสุด ไม่มีการเก็บข้อมูลหรือ telemetry, เปิดใช้งานคลาวด์ตามความสมัครใจเท่านั้น

- รองรับการทำงานออฟไลน์หลังดาวน์โหลดโมเดลแล้ว

-

ความยืดหยุ่นในการปรับใช้:

- รันเวิร์กโฟลว์ในเครื่องเพื่อความเป็นส่วนตัวสูงสุด หรือปรับใช้บนบริการคลาวด์ (RunPod, Google Cloud, เซิร์ฟเวอร์เฉพาะ)

- คำสั่งปรับใช้เพียงคำสั่งเดียว (

nodetool deploy) เพื่อจัดเตรียมโครงสร้างพื้นฐาน ดาวน์โหลดโมเดล และกำหนดค่าคอนเทนเนอร์ - ขยายการใช้งานเป็นศูนย์ จ่ายเฉพาะเวลาที่ inference ทำงานจริง

-

รองรับโมเดลทุกรูปแบบ:

- Inference ในเครื่อง:

- MLX (ปรับแต่งสำหรับ Apple Silicon สำหรับ LLMs, เสียง, การสร้างภาพ)

- Ollama (ตั้งค่าง่ายสำหรับ LLM ในเครื่อง)

- llama.cpp (Inference โมเดล GGUF ข้ามแพลตฟอร์มบน CPU/GPU)

- vLLM (เซิร์ฟเวอร์ระดับโปรดักชันพร้อม PagedAttention)

- Nunchaku (ประสิทธิภาพสูงสำหรับ Flux, Qwen, SDXL)

- ผู้ให้บริการคลาวด์:

- การเชื่อมต่อ API key โดยตรงสำหรับ OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai

- ผสมผสานผู้ให้บริการในเวิร์กโฟลว์เดียวได้

- การจัดการโมเดล: ค้นหา ดาวน์โหลด และจัดการน้ำหนักโมเดลจาก HuggingFace Hub ได้โดยตรงในแอป

- Inference ในเครื่อง:

-

ความสามารถมัลติโหมด:

ประมวลผลข้อความ, รูปภาพ, เสียง และวิดีโอภายในเวิร์กโฟลว์เดียวกัน -

บล็อกตัวสร้างจำนวนมาก:

มีส่วนประกอบพร้อมใช้กว่า 1000 รายการสำหรับโมเดล AI, การประมวลผลข้อมูล, การจัดการไฟล์, การคำนวณ, การควบคุม และอื่น ๆ -

ผู้ช่วยแชท:

โต้ตอบและรันเวิร์กโฟลว์ผ่านการสนทนาแบบธรรมชาติ -

ตัวจัดการทรัพยากรในตัว:

ระบบจัดการศูนย์กลางสำหรับรูปภาพ, เสียง, วิดีโอ, เอกสาร (PNG, JPG, GIF, SVG, WebP, MP3, WAV, MP4, MOV, AVI, PDF, TXT, JSON, CSV, DOCX)

ประโยชน์สำหรับผู้ใช้

- การเข้าถึง: สร้างเวิร์กโฟลว์ AI ซับซ้อนได้โดยไม่ต้องเขียนโค้ด ทำให้ AI ขั้นสูงเข้าถึงได้ง่ายสำหรับทุกคน

- ความโปร่งใส & การดีบัก: การทำงานแบบเรียลไทม์และตรวจสอบทีละขั้นตอนทำให้มองเห็นการทำงานอย่างเต็มที่และมั่นใจในผลลัพธ์

- ความเป็นส่วนตัว & การควบคุม: เก็บข้อมูลและโมเดลไว้ในเครื่อง เพื่อความเป็นส่วนตัวและความเป็นเจ้าของสูงสุด

- ความยืดหยุ่น: สามารถรันเวิร์กโฟลว์ในเครื่องหรือปรับใช้บนคลาวด์ ใช้โมเดลทั้งในเครื่องและคลาวด์ได้หลากหลาย

- ประหยัดต้นทุน: ใช้ inference ในเครื่องเพื่อลดค่าใช้จ่ายคลาวด์ และขยายเป็นศูนย์เมื่อเวิร์กโฟลว์ถูกปรับใช้

- ความหลากหลาย: สร้างแอปพลิเคชัน AI หลากหลาย เช่น ตัวแทนอัตโนมัติ, RAG, ท่อสร้างสรรค์ และการประมวลผลข้อมูล

- การสนับสนุนจากชุมชน: โอเพนซอร์สส่งเสริมการมีส่วนร่วมของชุมชน, แชร์เวิร์กโฟลว์ และเข้าถึงนักพัฒนาได้โดยตรง

ความเข้ากันได้และการรวมระบบ

- ระบบปฏิบัติการ: macOS, Windows, Linux

- ข้อกำหนดฮาร์ดแวร์: Nvidia GPU หรือ Apple Silicon M1+ และพื้นที่ว่างอย่างน้อย 20GB สำหรับดาวน์โหลดโมเดล

- การปรับใช้บนคลาวด์: RunPod, Google Cloud และเซิร์ฟเวอร์เฉพาะ

- การรวม API: OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai

- รองรับโมเดลในเครื่อง: MLX, Ollama, llama.cpp, vLLM, Nunchaku

วิธีเข้าถึงและเปิดใช้งาน

- ดาวน์โหลด: พร้อมดาวน์โหลดโดยตรงบน macOS, Windows และ Linux ผ่านเว็บไซต์หลัก

- โอเพนซอร์ส: ผู้ใช้สามารถตรวจสอบ แก้ไข และโฮสต์ระบบทั้งหมดเองได้ เนื่องจากเป็นโอเพนซอร์สภายใต้ใบอนุญาต AGPL-3.0