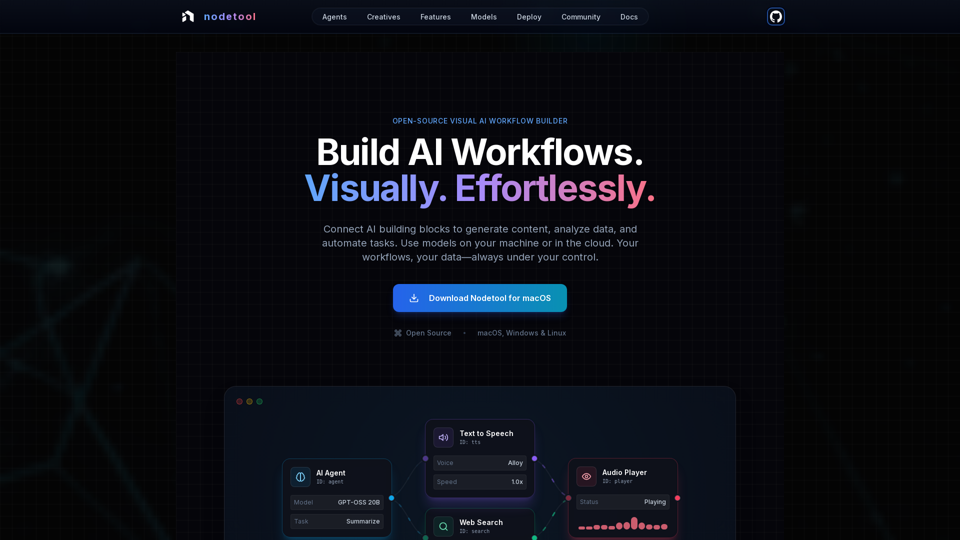

Особенности продукта Nodetool AI

Обзор

Nodetool AI — это open-source, локально ориентированный визуальный конструктор AI-воркфлоу для создания продвинутых LLM-агентов, RAG-пайплайнов и мультимодальных потоков данных. Он объединяет интерфейсы на базе узлов с мощными возможностями автоматизации, специально адаптированными под задачи ИИ, с акцентом на конфиденциальность, локальное исполнение и контроль пользователя.

Основная цель и целевая аудитория

- Основная цель: Предоставить единый, визуальный и не требующий кода платформу для построения, запуска и развертывания сложных AI-воркфлоу — от генеративного ИИ и медиапайплайнов до автономных агентов и интеллектуальной обработки документов.

- Целевая аудитория: Разработчики ИИ, дата-сайентисты, исследователи, творческие специалисты и все, кто желает создавать и автоматизировать AI-приложения без глубоких знаний в программировании, с особым вниманием к конфиденциальности, локальному контролю и open-source решениям.

Подробности функций и работы

-

Визуальная автоматизация воркфлоу:

- Канвас с функцией drag-and-drop для оркестрации LLM, инструментов обработки данных и API.

- Типобезопасные соединения, гарантирующие целостность воркфлоу.

- Мониторинг выполнения в реальном времени и пошаговый просмотр для прозрачности и отладки.

-

Генеративный AI и медиапайплайны:

- Соединение узлов для генерации видео, анализа текста, создания изображений и мультимодальной обработки.

- Поддержка моделей Flux, SDXL, OpenAI Sora, Google Veo и кастомных моделей.

-

Локально ориентированные RAG и векторные базы данных:

- Индексация документов и построение семантических поисковых пайплайнов полностью на локальной машине.

- Интегрированная ChromaDB для RAG.

-

Автономные AI-агенты:

- Создание агентов, способных вести поиск в интернете, серфить, использовать инструменты и реализовывать системы с несколькими агентами для решения сложных задач.

-

Open Source и архитектура, ориентированная на конфиденциальность:

- Лицензия AGPL-3.0, позволяющая инспектировать, модифицировать и самостоятельно размещать.

- Локальная обработка данных обеспечивает приватность; никакого сбора информации, отсутствие телеметрии, облако только по добровольной подписке.

- Поддержка офлайн-работы после загрузки моделей.

-

Гибкость развертывания:

- Запуск воркфлоу локально для максимальной приватности или развертывание в облаке (RunPod, Google Cloud, собственные серверы).

- Развертывание одной командой (

nodetool deploy) для подготовки инфраструктуры, загрузки моделей и настройки контейнеров. - Масштабирование до нуля с оплатой только за активное время инференса.

-

Универсальная поддержка моделей:

- Локальный инференс:

- MLX (оптимизация на Apple Silicon для LLM, аудио, генерации изображений).

- Ollama (простая настройка локальных LLM).

- llama.cpp (кроссплатформенный инференс моделей GGUF на CPU/GPU).

- vLLM (промышленные сервисы с PagedAttention).

- Nunchaku (высокопроизводительный инференс для Flux, Qwen, SDXL).

- Облачные провайдеры:

- Прямая интеграция API ключей OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai.

- Возможность комбинировать провайдеров в одном воркфлоу.

- Управление моделями: Поиск, загрузка и управление весами моделей с HuggingFace Hub прямо в приложении.

- Локальный инференс:

-

Мультимодальные возможности:

Обработка текста, изображений, аудио и видео в одном воркфлоу. -

Широкий набор строительных блоков:

Более 1000 готовых компонентов для AI-моделей, обработки данных, операций с файлами, вычислений, управления и прочего. -

Чат-ассистент:

Взаимодействие с воркфлоу и их запуск через естественный диалог. -

Встроенный менеджер ассетов:

Централизованное управление изображениями, аудио, видео и документами (PNG, JPG, GIF, SVG, WebP, MP3, WAV, MP4, MOV, AVI, PDF, TXT, JSON, CSV, DOCX).

Пользовательские преимущества

- Доступность: Постройка сложных AI-воркфлоу без программирования, делая продвинутый ИИ доступным для каждого.

- Прозрачность и отладка: Мониторинг выполнения и пошаговая проверка обеспечивают полную видимость и уверенность в работе воркфлоу.

- Конфиденциальность и контроль: Данные и модели остаются локальными для максимальной приватности и права собственности.

- Гибкость: Запуск локально или развертывание в облаке с использованием широкого спектра моделей.

- Экономия: Использование локального инференса снижает расходы на облако, масштабирование до нуля при деплое.

- Универсальность: Создание разнообразных AI-приложений — от агентов и RAG до творческих пайплайнов и обработки данных.

- Поддержка сообщества: Open-source характер стимулирует вклад сообщества, обмен воркфлоу и прямой контакт с разработчиками.

Совместимость и интеграция

- Операционные системы: macOS, Windows, Linux.

- Требования к железу: Nvidia GPU или Apple Silicon M1+ и минимум 20 ГБ свободного места для загрузки моделей.

- Облачное развертывание: RunPod, Google Cloud и собственные серверы.

- Интеграции API: OpenAI, Anthropic, Gemini, OpenRouter, Cerebras, Minimax, HuggingFace, Fal AI, Replicate, Kie.ai.

- Поддержка локальных моделей: MLX, Ollama, llama.cpp, vLLM, Nunchaku.

Способ доступа и активации

- Загрузка: Доступен для прямой загрузки на macOS, Windows и Linux с официального сайта.

- Open Source: Пользователи могут инспектировать, модифицировать и самостоятельно хостить весь стек благодаря лицензии AGPL-3.0.